Explique ce qu’est un code de bonne conduite numérique et donne des indications sur les éléments qu’il devrait contenir. Le code de bonne conduite peut porter plusieurs noms : nétiquette, e-étiquette, politique de citoyenneté numérique, etc.

1.1 Qu’est-ce qu’un « code de bonne conduite numérique »?

Le code de bonne conduite numérique renferme l’ensemble des règlements quant à l’utilisation d’une plateforme participative. C’est à partir de ces règles que s’opère la modération du contenu et des usagers. Il s’agit d’un outil efficace pour éduquer vos usagers à la culture du web participatif et ainsi contribuer à maintenir un climat à la fois sécuritaire et respectueux sur votre plateforme.

1.2 Quels éléments inclure dans son code de bonne conduite numérique?

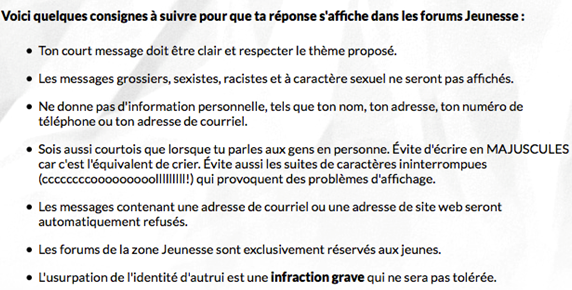

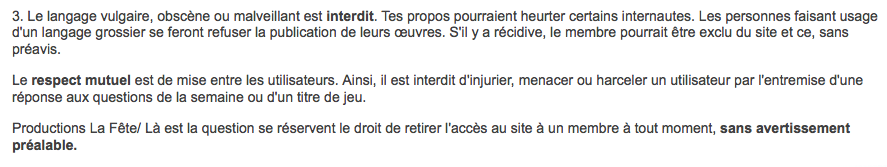

Les thématiques courantes à couvrir sont le partage d’informations personnelles, le manque de respect envers les autres usagers, les contenus et sujets de conversations inappropriés et les comportements perturbateurs (spamming, abus du mécanisme de signalement, etc.). Il peut être utile aussi de rappeler les principes du droit d’auteur pour éviter que des usagers publient des œuvres protégées, de façon intentionnelle ou non.Dans un langage adapté au public, le code de bonne conduite numérique doit énumérer de la manière la plus exhaustive possible les droits et responsabilités, les attentes et les conséquences lors d’une infraction. Le code devrait préciser quelles sont les conséquences si les règles ne sont pas respectées, par exemple la suppression du contenu, la suspension ou la fermeture du compte de l’usager.

1.3 Comment doit-on intégrer le code de bonne conduite sur la plateforme?

Il n’existe pas de méthode universelle pour présenter un code de bonne conduite numérique. Son importance va varier grandement en fonction du type de plateforme et de la quantité d’activités participatives qu’elle contient. Par exemple, dans un réseau social où il y a plusieurs possibilités d’interactions entre les usagers, le code de bonne conduite numérique peut prendre la forme d’un contrat et son acceptation par l’utilisateur devient une condition préalable à sa participation.

- Certaines plateformes intègrent leur code de bonne conduite numérique à même leurs conditions d’utilisation, mais en production jeunesse, vous avez avantage à en faire un document à part entière pour démontrer votre engagement envers la sécurité de vos usagers;

- Faites en sorte que les parents aient accès en tout temps au code de bonne conduite numérique;

- Si votre public est d’âge préscolaire, le code devrait s’adresser aux parents et se retrouver dans la section réservée aux parents;

- Si votre plateforme s’y porte, intégrez votre code de bonne conduite numérique de manière ludique pour augmenter la motivation des enfants à mettre les règles en pratiques;

- Évitez le jargon juridique : il doit être écrit dans un langage familier, adapté au niveau de maturité de votre public. Par exemple, utilisez des formulations familières, comme : « Quand tu viens jouer ici, tu n’as pas le droit de […] »;

- L’énoncé d’une règle doit être précis. Au besoin, vous pouvez illustrer avec des exemples les idées plus complexes. Un énoncé tel que « Attention à votre vie privée! Vous ne devez pas partager d’informations personnelles à travers l’outil de clavardage » pourrait être complété avec la liste de ce que constitue une information personnelle;

- Graduez les sanctions en fonction de l’infraction et du nombre d’offenses de l’usager : un avertissement, retirer le contenu, bloquer le compte pour une journée, fermer le compte, etc.;

- Faites du code de bonne conduite numérique une condition de participation : exigez que l’usager coche une case « Je confirme avoir lu et accepté » avant de lui donner accès à la plateforme.